In der heutigen digitalen Welt ist der Schutz unserer Geräte vor Malware und Cyberbedrohungen unerlässlich. Zahlreiche Antivirenprogramme stehen zur Auswahl, darunter prominente Namen wie G Data und Kaspersky, die sich stets um die Gunst der Nutzer bemühen. Doch wie effektiv sind diese Lösungen wirklich, und wie verlässlich sind die Vergleichstests, die uns dabei helfen sollen, die beste Wahl zu treffen? Oftmals versprechen diese Tests Transparenz und eindeutige Ergebnisse, doch bei genauerem Hinsehen offenbaren sich methodische Mängel, die die wahre Leistungsfähigkeit der Produkte, inklusive jener von Kaspersky 2010, verschleiern können.

Leider gibt es nicht viele Tests, denen man uneingeschränkt vertrauen und die man guten Gewissens empfehlen kann. Die Testmethoden weisen zu viele Mängel auf, sodass die Tests oft nur eine Momentaufnahme der überprüften Produkte liefern und das Gesamtbild verfehlen – genau das aber, was Kunden eigentlich benötigen. Ein Großteil der Tests hält noch an veralteten Praktiken fest, wie zum Beispiel On-Demand-Tests mit veralteten Malware-Sammlungen, die nicht die aktuellen realen Nutzungsszenarien widerspiegeln.

Warum aktuelle Antivirus-Tests oft irreführend sind

Die Landschaft der Antiviren-Tests ist komplex. Während viele Organisationen versuchen, einen objektiven Vergleich zu liefern, scheitern sie oft an den Feinheiten moderner Bedrohungen und Nutzergewohnheiten. Die Hauptprobleme liegen in der Methodik, die entweder nicht dynamisch genug ist oder wichtige Aspekte außer Acht lässt. Dies betrifft alle getesteten Produkte, von etablierten Größen wie G Data bis hin zu Lösungen wie Kaspersky 2011, die mit spezifischen Herausforderungen konfrontiert sind.

Ein gravierender Mangel vieler Tests ist die Verwendung von statischen, oft veralteten Malware-Sammlungen. Cyberbedrohungen entwickeln sich jedoch ständig weiter, und was gestern eine relevante Bedrohung war, kann heute bereits veraltet sein. Reale Nutzungsszenarien umfassen eine kontinuierliche Exposition gegenüber neuen und unbekannten Bedrohungen, sogenannte Zero-Day-Exploits. Tests, die diesen dynamischen Aspekt nicht ausreichend berücksichtigen, können die tatsächliche Schutzwirkung eines Antivirenprogramms nur unzureichend abbilden.

Die Notwendigkeit einer realistischen Betrachtung

Für Endnutzer, die sich zwischen Lösungen wie G Data und Kaspersky entscheiden müssen, ist es entscheidend, dass Testergebnisse die Realität widerspiegeln. Ein Antivirenprogramm mag in einem Labor-Setting hervorragend abschneiden, aber im täglichen Gebrauch zu einer erheblichen Systemverlangsamung führen. Umgekehrt kann ein Produkt, das in reinen Leistungsbenchmarks nicht ganz oben steht, in puncto Benutzerfreundlichkeit und tatsächlicher Schutzwirkung überzeugen. Es geht darum, ein Gleichgewicht zu finden, das über bloße Zahlen hinausgeht und die gesamte Nutzererfahrung berücksichtigt.

Der PassMark-Test im Fokus: Eine Analyse der Methodik

PassMark ist eine sehr angesehene Organisation, deren Arbeit ich bewundere. Ihr jüngster Antivirus-Leistungstest weist jedoch mindestens einen erheblichen Fehler auf, der Leser in die Irre führen und zu Kaufentscheidungen führen könnte, die auf fehlerhaften Vergleichen basieren.

PassMark führt Benchmarking-Tests verschiedener Antivirenprodukte durch, genauer gesagt, es testet, wie stark Antivirenprogramme ein Standardsystem verlangsamen. Im jüngsten Test wurden die Produkte von fünf Unternehmen verglichen, die bereits ihre 2012er-Versionen veröffentlicht hatten: Avast!, G Data, Kaspersky Lab, Panda und Symantec.

Die Ergebnisse sahen Symantec auf dem ersten Platz, gefolgt von Avast! auf dem zweiten und uns (Kaspersky) auf dem dritten. Wir werden keine Kommentare oder Urteile zur Objektivität oder Unparteilichkeit des Tests abgeben, da PassMark in dieser Hinsicht nichts verbirgt: Die veröffentlichten Ergebnisse enthalten einen Disclaimer, der explizit besagt, dass der Test subventioniert und gemäß der Methodik eines der Teilnehmer durchgeführt wurde:

Symantec Corporation funded the production of this report and supplied some of the test scripts used for the tests.

Was vielleicht noch interessanter ist: Dieser Disclaimer war bereits in PassMarks früheren Antiviren-Leistungstests (2010, 2009, 2008) vorhanden. Können Sie erraten, wer all diese Tests gewonnen hat?

Doch ungeachtet des Kleingedruckten: Ein veröffentlichter Test einer angesehenen Benchmarking-Organisation bleibt ein veröffentlichter Test einer angesehenen Benchmarking-Organisation. Trotz des Disclaimers sieht es für den Sieger gut aus: Er preist seinen Sieg in aller Öffentlichkeit an (nur natürlich – wer würde das nicht?), die Öffentlichkeit applaudiert dem Sieg, ist begeistert und kauft natürlich eher das Produkt. Es wäre sehr interessant zu erfahren, wie genau bestimmte „bereitgestellte Skripte“ die Abstimmung beeinflussten, um den Sponsor auf den Thron zu heben.

Alles, was man tun muss, ist, diesen Test etwas genauer zu betrachten, um zu erkennen, was er wirklich ist. Das erste, was auffällt, ist, dass die Punkte, die für jeden der getesteten Parameter vergeben werden können, gleichwertig sind; das heißt, ein trivialer Parameter – wenn er gut ist – erhält die gleiche Punktzahl wie ein äußerst wichtiger Parameter, der gut ist.

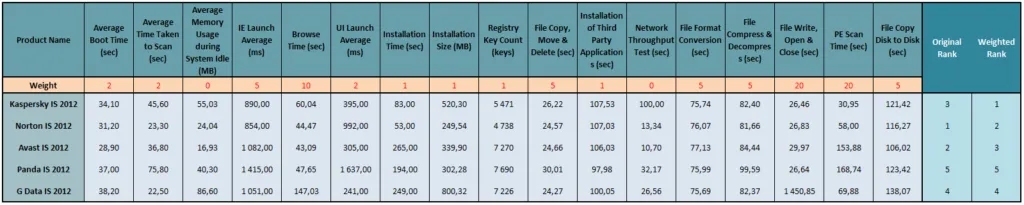

Hier ist jedenfalls, wie der Test durchgeführt wurde. Jedes Produkt wird anhand von 17 Leistungsparametern gemessen (Startzeit, Internet Explorer-Startzeit, Dateiöffnungs- und Kopierzeit usw.). Dann werden die Produkte nach ihren erzielten Punktzahlen in jedem Test eingestuft, und dann werden die Ranglisten summiert, und wer die höchsten Noten erhält, gewinnt.

Aber, um es noch einmal zu betonen, es wird davon ausgegangen, dass ein Benutzer gleich große Bedeutung solchen Parametern beimisst wie „Produktinstallationszeit“(!), „Geschwindigkeit beim Packen/Entpacken von Archiven“, „Anzahl der hinzugefügten Registrierungsschlüssel“ und „Netzwerkdurchsatz“. Aber für mich sind diese Parameter in keiner Weise gleich wichtig! Und ich habe keinen Zweifel, dass Sie dasselbe denken.

Der Wert der Gewichtung: Eine personalisierte Perspektive

Ich habe mich daher entschieden, jedem Messwert eine Gewichtung, d.h. einen Grad der Wichtigkeit, zuzuweisen und mir dann die „korrigierten“ Ergebnisse anzusehen.

Die Gewichtungen sind wie folgt:

- 0 – Ich halte die Messung für irrelevant für reale Situationen.

- 1 – Diese Aktion wird sehr selten ausgeführt, nicht öfter als einmal im Jahr.

- 2 – Diese Aktion wird ein- oder zweimal pro Woche ausgeführt, nicht öfter.

- 5 – Eine Aktion, die einmal am Tag, vielleicht zwei- oder dreimal am häufigsten ausgeführt wird.

- 10 – Wird oft ausgeführt.

- 20 – Wird sehr oft oder ständig ausgeführt – d.h. die wichtigsten Aktionen.

Für ein Szenario, das auf meiner täglichen Arbeit basiert, ergab sich Folgendes:

- Test 1: Startzeit. Wird nicht oft genutzt. Gewichtung – 2

- Test 2: On-Demand-Scanzeit. Selten genutzt. Gewichtung – 2

- Test 3: Speichernutzung im Leerlauf. Ich bin der festen Überzeugung, dass Antivirenprogramme bestimmte ressourcenintensive Aufgaben auf die Leerlaufzeit des PCs verschieben sollten, um ihn während der „Arbeitszeit“ nicht zu überlasten. Irrelevante Metriken und Messungen. Daher Gewichtung – 0.

- Test 4: Internet Explorer-Startzeit. Gewichtung – 5.

- Test 5: Internet Explorer-Surfzeit. Wenn jemand ununterbrochen klickt, ohne zu warten, bis er den Inhalt gelesen hat, dann sollte die Gewichtung natürlich 20 sein. Für mich: Gewichtung – 10.

Und so weiter (siehe Tabelle unten). Aber lassen Sie mich Ihnen noch von einigen weiteren Tests erzählen, die einer Erklärung bedürfen:

- Test 8: Installationsgröße. Äh? Wie in aller Welt beeinflusst das die reale Leistung der getesteten Produkte? Und für einen besseren Vergleich sollte auch die „Größe der während der Installation heruntergeladenen Daten“ bewertet werden. Aber lassen wir das. Gewichtung – 1.

- Test 9: Anzahl der hinzugefügten Registrierungsschlüssel. Nun, das ist einfach zum Lachen. Vielleicht möchten sie auch die Anzahl der Dateien auf der Festplatte zählen, oder vielleicht die Anzahl der Buchstaben in den Dateinamen? Gewichtung – 1.

- Test 12: Kopiergeschwindigkeit von Dateien aus dem Internet („Netzwerkdurchsatztest“). Aus irgendeinem Grund konnte PassMark unser Ergebnis dafür nicht messen. Dann haben sie sich selbst sortiert und wären in der Lage gewesen, es zu messen, aber da war es schon zu spät. Das Ergebnis war, dass die Messung irrelevant war. Gewichtung – 0.

- Tests 15/16: Datei öffnen, lesen und schreiben, und PE-Scanzeit. Das ist das Wichtigste! Die Leistung von Produkten sollte danach beurteilt werden! Gewichtung – 20.

- Test 17: Dateikopie von Festplatte zu Festplatte. Da Heimprodukte getestet wurden, sehe ich die Relevanz dafür überhaupt nicht. Selbst wenn Sie mehr als eine lokale Festplatte hätten, warum sollten Sie Dateien von einer Festplatte auf eine andere kopieren wollen? Aber wie auch immer. Gewichtung – 3.

Wenn wir nun die Noten unter Berücksichtigung der neuen Gewichtungen berechnen – raten Sie mal? Ja, genau, das Ergebnis ist für Symantec nicht so gut (klicken Sie auf das Bild, um Details zu sehen). Dieses Szenario zeigt deutlich, dass die vermeintliche Überlegenheit von Symantec gegenüber Lösungen wie G Data oder Kaspersky 2020 bei einer realistischeren Betrachtung schwinden kann.

Diese Ergebnisse basieren natürlich auf meinen persönlichen Vorlieben. Jeder hat seine eigenen. Das Wichtigste, was man aus der oben genannten Methodikanalyse mitnehmen sollte, ist, zu wissen, dass man nicht alles, was man in Tests liest – nämlich deren Ergebnisse – für bare Münze nehmen sollte. Besonders die Ergebnisse von Tests mit eindeutigen Disclaimern. Für Nutzer, die nach dem Download von Kaspersky 11.9 Download eine fundierte Entscheidung treffen möchten, ist diese kritische Haltung unerlässlich.

Und noch ein Gedanke: Ich denke, es wäre keine schlechte Idee, ein Applet zu schreiben, bei dem Benutzer jedem Testparameter je nach ihrer alltäglichen Computererfahrung ihre eigenen Gewichtungen zuweisen können. Sie könnten ihr eigenes persönliches, maßgeschneidertes Ergebnis für das Antivirenprogramm erhalten, das am besten für sie ist. Dies würde auch eine fairere Vergleichsbasis für Produkte wie G Data und Kaspersky Total Security 22 schaffen.

Der Fairness halber sollte ich anmerken, dass nicht nur dieser Test unter den genannten Mängeln leidet. Leider kümmern sich praktisch alle Benchmarking-Tests nicht um Gewichtungen, sondern werfen Äpfel und Orangen, Birnen und Pfirsiche – und Bananen und Hamster – alle zusammen als gleichwertig.

Die Herausforderung der Antivirus-Bewertung: Wem kann man vertrauen?

Sie fragen sich vielleicht, wem Sie dann noch glauben sollen. Wer kann die Qualität einer Antivirenlösung maßgeblich messen?

Die Antwort ist einfach: Es gibt wirklich keinen solchen Test – einen, den ich als den besten Indikator zweifelsfrei empfehlen könnte.

Bei einem gibt es eine mangelhafte Methodik, bei einem anderen ist er zu spezifisch und so weiter. Mein Rat ist, einige der verfügbaren Optionen zu prüfen und sich niemals nur auf eine zu verlassen. Schauen Sie sich einige Tests an, wie die von Andreas Marx’ AV-Test, Andreas Clementis AV-Comparatives, und Anti-Malware Test Lab, Virus Bulletin und Matousec, die nicht von Andreasen betrieben werden. Diese Institutionen bieten wertvolle Einblicke, die über die einfachen Benchmarks hinausgehen und eine fundiertere Bewertung der Leistungsfähigkeit von Antivirenprogrammen, einschließlich G Data und Kaspersky, ermöglichen.

Fazit und Empfehlungen für eine informierte Entscheidung

Die Auswahl des richtigen Antivirenprogramms ist eine persönliche Entscheidung, die weit über das hinausgeht, was oberflächliche Leistungstests vermitteln können. Es ist entscheidend, dass Nutzer die Testmethoden kritisch hinterfragen und verstehen, welche Parameter für ihr individuelles Nutzungsverhalten am relevantesten sind. Verlassen Sie sich nicht blind auf eine einzelne Quelle oder einen einzigen Gewinner, der möglicherweise durch fragwürdige Methoden ermittelt wurde.

Stattdessen empfehle ich Ihnen:

- Bilden Sie sich eine eigene Meinung: Überlegen Sie, welche Aspekte (Systemleistung, Erkennungsrate, Benutzerfreundlichkeit) für Sie persönlich am wichtigsten sind.

- Konsultieren Sie mehrere, unabhängige Quellen: Vergleichen Sie die Ergebnisse von renommierten Testlaboren wie AV-Test, AV-Comparatives und Virus Bulletin.

- Achten Sie auf Transparenz: Suchen Sie nach Tests, die ihre Methodik offenlegen und mögliche Interessenskonflikte klar kommunizieren.

- Testen Sie selbst: Viele Antivirenprogramme bieten kostenlose Testversionen an. Nutzen Sie diese, um zu sehen, wie sich Produkte wie G Data oder Kaspersky in Ihrem spezifischen System und bei Ihren täglichen Aufgaben verhalten.

Indem Sie diese Schritte befolgen, können Sie eine fundierte Entscheidung treffen, die Ihren individuellen Anforderungen an Sicherheit und Leistung am besten entspricht und Sie nicht nur auf die Aussagekraft eines einzelnen Benchmarks vertrauen.

Referenzen

- PassMark: www.passmark.com

- AV-Test: www.av-test.org

- AV-Comparatives: www.av-comparatives.org

- Anti-Malware Test Lab: www.anti-malware-test.com

- Virus Bulletin: www.virusbtn.com/vb100/index

- Matousec: www.matousec.com

- Kaspersky Blog (Originalartikel): Features You’d Normally Never Hear About

- Kaspersky Blog (Originalartikel Teil 2): Features You’d Normally Never Hear About, Part Two

- PassMark Antivirus Performance Tests: